هنگامی که اوایل این هفته یک تصویر تولید شده توسط هوش مصنوعی از انفجاری که در خارج از پنتاگون رخ میدهد در رسانههای اجتماعی وایرال شد، پیشنمایش کوتاهی از فاجعه اطلاعات دیجیتالی که محققان هوش مصنوعی برای سالها نسبت به آن هشدار دادهاند ارائه کرد. این تصویر به وضوح جعل شده بود اما باز هم تماسهای زیادی با پلیس و رسانهها گرفته شد که به سبک 11 سپتامبر 2001 در جریان است. هرجومرج متعاقب آن موج شوک کوتاهی را به بازار سهام وارد کرد و باعث وحشت همگانی شد.

شکست پنتاگون در عرض چند ساعت حل شد، اما اوضاع میتوانست بسیار بدتر از این باشد. در اوایل سال جاری، جفری هینتون، دانشمند کامپیوتر که برخی از او به عنوان «پدرخوانده هوش مصنوعی» یاد میکنند، گفت که نگران است کیفیت متقاعدکنندهتر تصاویر تولید شده توسط هوش مصنوعی افراد عادی را به این سمت سوق دهد که «نتوانند بفهمند چه کسی حقیقت را میگوید».

استارتآپها و شرکتهای مستقر هوش مصنوعی همزمان در حال رقابت برای توسعه ابزارهای جدید تشخیص عمیق هوش مصنوعی هستند تا از وقوع این فاجعه جلوگیری کنند.

برخی از این تلاشها برای سالها سابقه دارند، اما انفجار ناگهانی هوش مصنوعی مولد و هوشیاری جریان اصلی نسبت به OpenAI’s DALL-E و ChatGPT منجر به افزایش احساس فوری سرمایهگذاری بیشتر برای ایجاد راهی برای شناسایی آسان محصولات هوش مصنوعی شده است.

شرکتهایی که برای یافتن راهحلهای تشخیص رقابت میکنند، این کار را در تمام سطوح محتوا انجام میدهند؛ از شناسایی محتوای متنی تا شناسایی کدهای عکسها و ویدئوهای تولید شده توسط هوش مصنوعی. به طور مشخص این حوزهای است که به سرمایهگذاری بیشتر و اکتشاف بیشتر نیاز دارد.

در اینجا برخی از شرکتهایی که در رقابت برای شناسایی دیپفیک پیشرو هستند را مرور میکنیم.

Intel FakeCatcher

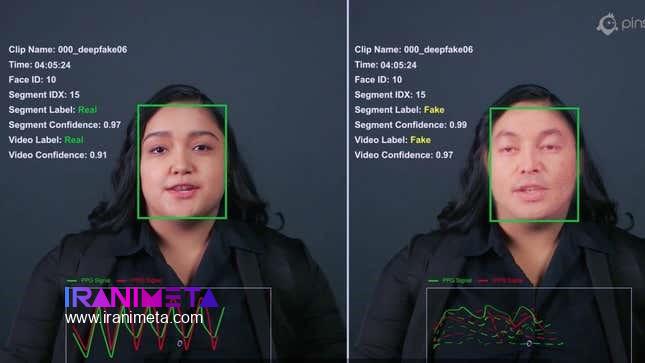

تراشه ساز مشهور و شناخته شده، اینتل در تحقیقات هوش مصنوعی بازیگر شناخته شده است. اکنون این غول مشهور فناوری از این دانش برای ایجاد FakeCatcher استفاده میکند، یک فناوری تشخیص دیپفیک «در لحظه» که ادعا میکند میتواند ویدئوهای هوش مصنوعی را در ۹۶ درصد مواقع شناسایی کند.

برخلاف سایر آشکارسازها که به کد منبع خام یک فایل یا سند نگاه میکنند، FakeCatcher در واقع چهرهها را در رسانهها تجزیهوتحلیل میکند تا تغییرات جریان خون انسانی را تشخیص دهد، تغییراتی که در هوش مصنوعی قابل شبیهسازی نیست. این سیستم همچنین سیستم تشخیص مبتنی بر چشم را دارد که روی این متمرکز است که سوژه انسان است یا توسط هوش مصنوعی تولید شده است.

Microsoft

مدتها قبل از اینکه مایکروسافت بخواهد موتور جستجوی Bing خود را با ادغام ChatGPT احیا کند، غول فناوری دنیا به دنبال راههایی برای شناسایی دیپفیک بود. در سال 2020، این شرکت Microsoft Video Authenticator را معرفی کرد که عکسها یا ویدئوها را تجزیهوتحلیل میکند و درصد احتمال دیپفیک بودن محتوا را به شما میگوید. مایکروسافت میگوید آشکارسازش میتواند این کار را با شناسایی عناصر خاکستری و جزئیات کوچک که احتمالاً برای چشم انسان غیر قابل تشخیص هستند، انجام دهد.

آشکارساز مایکروسافت در زمان خود پیشرفته به نظر می رسید، اما مشخص نیست که این سیستم تا چه اندازه در برابر هجوم فناوری جدید تولیدکنندگان تصویر هوش مصنوعی که در سه سال گذشته ظاهر شده اند مقاوم و درست است. مایکروسافت خودش اعتراف کرده که انتظار ندارد آشکارسازش به سرعت دیپفیک پیشرفت کند.

DARPA

DARPA، بخش تحقیق و توسعه بدون محدودیت ارتش ایالات متحده، حداقل از سال 2019 برنامه ای برای بررسی راه های تشخیص محتواهای تولید شده توسط هوش مصنوعی داشته است. برنامه Semantic Forensic دارپا (SemaFor) بر ایجاد “الگوریتم های تحلیل معنایی و آماری” متمرکز شده است. دفاع در برابر تصاویر دستکاری شده برای جلوگیری از انتشار اطلاعات نادرست اولویت این برنامه است. این برنامه همچنین در حال توسعه الگوریتمهای انتساب برای تعیین منشأ یک تصویر جعلی است و سعی میکند مشخص کند که تصویر برای اهداف خوشخیم تولید شده یا احتمالاً بخشی از کمپین اطلاعات نادرست مضر ایجاد شده توسط دولتهای رقیب یا جریانها سیاسی است.

OpenAI

OpenAI تقریباً به تنهایی توانسته است با مولدهای تصویر DALL-E و ChatGPT محبوب خود، با سرعت و کیفیتی خاص از هوش مصنوعی مولد استفاده کند. اکنون، این شرکت در تلاش است تا فیلترهای هوش مصنوعی را توسعه دهد.

فیلتر کننده متن OpenAI تا اینجای کار، عالی عمل نکرده است. OpenAI میگوید طبقهبندیکنندهاش تنها توانست 26 درصد متون نوشته شده توسط هوش مصنوعی را بهعنوان متن نوشته شده توسط هوش مصنوعی به درستی شناسایی کند. بدتر از آن، همان سیستم به اشتباه 9 درصد از محتوای تألیف شده توسط انسان را به عنوان محتوای تولید شده توسط هوش مصنوعی مشخص کرد.

OpenAI میگوید: فیلتر ما کاملا قابل اعتماد نیست. این نباید به عنوان یک ابزار تصمیم گیری اولیه استفاده شود، بلکه باید به عنوان مکملی برای روش های دیگر تعیین منبع استفاده شود.

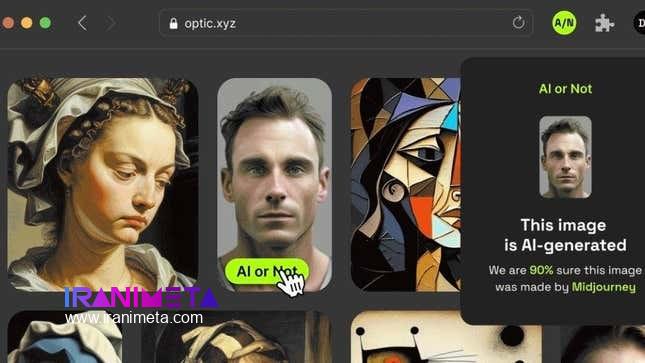

Optic

استارتآپ Optic که تشخیص دهنده حرفهای دیپفیک است، جسورانه ادعا میکند که میتواند تصاویر تولید شده توسط هوش مصنوعی Stable Diffusion، Midjourney، DALL-E و Gan.ai را شناسایی کند. کاربران به سادگی باید تصویر مشکوک مورد نظر را در وب سایت Optic آپلود کنند یا آن را به یک ربات در تلگرام ارسال کنند و این شرکت دست به تشخیص میزند.

Optic با ارائه درصدی نشان می دهد سیستمش چقدر مطمئن است که تصویر ارسال شده توسط هوش مصنوعی تولید شده است. همچنین تلاش میکند تا مشخص کند که از کدام مدل خاص برای ایجاد تصویر استفاده شده است. اگرچه Optic ادعا میکند که قادر است تصاویر تولید شده با هوش مصنوعی را در 96٪ مواقع به درستی شناسایی کند، اما تجربه نشان داده این شرکت بی اشتباه نیست. رسانه Gizmodo از مدل Optic درخواست کرد که صحت تصویر کاملاً تقلبی یک انفجار احتمالی در نزدیکی پنتاگون را تعیین کند و Optic تشخیص داد که “توسط یک انسان تولید شده است”.